根#

- scipy.optimize.root(fun, x0, args=(), method='hybr', jac=None, tol=None, callback=None, options=None)[source]#

寻找向量函数的根。

- 参数:

- fun可调用对象

寻找根的向量函数。

假设该可调用对象具有签名

f0(x, *my_args, **my_kwargs),其中my_args和my_kwargs是必需的位置参数和关键字参数。不应直接传递f0作为可调用对象,而是将其封装以仅接受x;例如,将fun=lambda x: f0(x, *my_args, **my_kwargs)作为可调用对象传递,其中my_args(元组)和my_kwargs(字典)已在该函数调用前收集。- x0ndarray

初始猜测值。

- args元组, 可选

传递给目标函数及其雅可比矩阵的额外参数。

- methodstr, 可选

求解器类型。应为以下之一:

- jac布尔值或可调用对象, 可选

如果jac是布尔值且为 True,则假定fun返回雅可比矩阵的值以及目标函数。如果为 False,则雅可比矩阵将通过数值方法估计。jac也可以是一个可调用对象,返回fun的雅可比矩阵。在这种情况下,它必须接受与fun相同的参数。

- tolfloat, 可选

终止容差。如需详细控制,请使用求解器特定选项。

- callback函数, 可选

可选的回调函数。它在每次迭代时被调用,形式为

callback(x, f),其中x是当前解,而f是相应的残差。适用于除 ‘hybr’ 和 ‘lm’ 之外的所有方法。- optionsdict, 可选

求解器选项的字典。例如,xtol或maxiter,详情请参见

show_options()。

- 返回值:

- solOptimizeResult

表示为

OptimizeResult对象的解。重要属性包括:x解数组,success一个布尔标志,指示算法是否成功退出,以及message描述终止原因的字符串。更多属性说明请参见OptimizeResult。

另请参见

show_options求解器接受的额外选项

注意事项

本节描述了可通过 ‘method’ 参数选择的可用求解器。默认方法是hybr。

方法hybr使用鲍威尔混合方法的修改版本,该版本在 MINPACK [1]中实现。

方法lm使用莱文贝格-马夸特算法的修改版本,以最小二乘意义求解非线性方程组,该版本在 MINPACK [1]中实现。

方法df-sane是一种无导数谱方法。[3]

方法broyden1、broyden2、anderson、linearmixing、diagbroyden、excitingmixing、krylov是非精确牛顿方法,带有回溯或完整线搜索[2]。每种方法对应于特定的雅可比矩阵近似。

方法broyden1使用 Broyden 第一雅可比近似,它被称为 Broyden 优良方法。

方法broyden2使用 Broyden 第二雅可比近似,它被称为 Broyden 劣质方法。

方法anderson使用(扩展)安德森混合法。

方法Krylov使用求解逆雅可比矩阵的 Krylov 近似。它适用于大规模问题。

方法diagbroyden使用对角 Broyden 雅可比近似。

方法linearmixing使用标量雅可比近似。

方法excitingmixing使用调优对角雅可比近似。

警告

为方法diagbroyden、linearmixing和excitingmixing实现的算法可能对特定问题有用,但它们是否有效可能很大程度上取决于具体问题。

在 0.11.0 版本中添加。

参考文献

[2]C. T. Kelley. 1995. 线性与非线性方程的迭代方法。工业与应用数学学会。<https://archive.siam.org/books/kelley/fr16/>

[3]La Cruz, J.M. Martinez, M. Raydan. Math. Comp. 75, 1429 (2006)。

示例

以下函数定义了一个非线性方程组及其雅可比矩阵。

>>> import numpy as np >>> def fun(x): ... return [x[0] + 0.5 * (x[0] - x[1])**3 - 1.0, ... 0.5 * (x[1] - x[0])**3 + x[1]]

>>> def jac(x): ... return np.array([[1 + 1.5 * (x[0] - x[1])**2, ... -1.5 * (x[0] - x[1])**2], ... [-1.5 * (x[1] - x[0])**2, ... 1 + 1.5 * (x[1] - x[0])**2]])

解决方案可以按如下方式获得。

>>> from scipy import optimize >>> sol = optimize.root(fun, [0, 0], jac=jac, method='hybr') >>> sol.x array([ 0.8411639, 0.1588361])

大规模问题

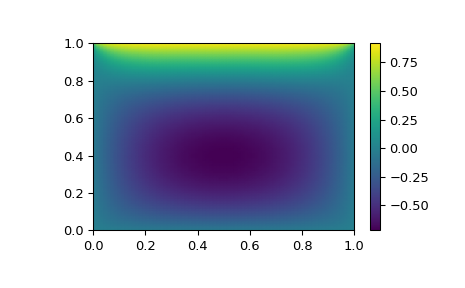

假设我们需要在正方形\([0,1]\times[0,1]\)上求解以下积分微分方程

\[\nabla^2 P = 10 \left(\int_0^1\int_0^1\cosh(P)\,dx\,dy\right)^2\]其中\(P(x,1) = 1\)以及正方形边界上的其他地方\(P=0\)。

可以使用

method='krylov'求解器找到解决方案>>> from scipy import optimize >>> # parameters >>> nx, ny = 75, 75 >>> hx, hy = 1./(nx-1), 1./(ny-1)

>>> P_left, P_right = 0, 0 >>> P_top, P_bottom = 1, 0

>>> def residual(P): ... d2x = np.zeros_like(P) ... d2y = np.zeros_like(P) ... ... d2x[1:-1] = (P[2:] - 2*P[1:-1] + P[:-2]) / hx/hx ... d2x[0] = (P[1] - 2*P[0] + P_left)/hx/hx ... d2x[-1] = (P_right - 2*P[-1] + P[-2])/hx/hx ... ... d2y[:,1:-1] = (P[:,2:] - 2*P[:,1:-1] + P[:,:-2])/hy/hy ... d2y[:,0] = (P[:,1] - 2*P[:,0] + P_bottom)/hy/hy ... d2y[:,-1] = (P_top - 2*P[:,-1] + P[:,-2])/hy/hy ... ... return d2x + d2y - 10*np.cosh(P).mean()**2

>>> guess = np.zeros((nx, ny), float) >>> sol = optimize.root(residual, guess, method='krylov') >>> print('Residual: %g' % abs(residual(sol.x)).max()) Residual: 5.7972e-06 # may vary

>>> import matplotlib.pyplot as plt >>> x, y = np.mgrid[0:1:(nx*1j), 0:1:(ny*1j)] >>> plt.pcolormesh(x, y, sol.x, shading='gouraud') >>> plt.colorbar() >>> plt.show()